Руководитель проекта: Жолтаев Дархан Муратович

Источник финансирования: ГФ молодых ученых по проекту «Жас ғалым»

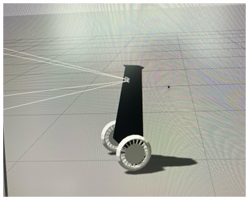

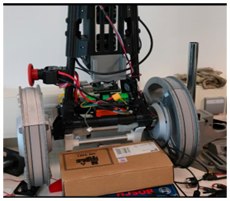

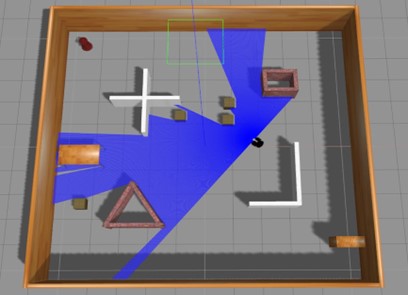

Цель: Цель состоит в том, чтобы усовершенствовать алгоритмы глубокого обучения с подкреплением (ГОП) с использованием жидкостные нейронные сети (ЖСН) и модели большого языка (МБЯ), для создания более адаптивных и эффективных систем ГОП. Будет тестированы эти алгоритмы на сложных электромеханических системах, эффективности системы и ее адаптируемости в динамических средах.

Годы реализации: 2024–2026

Объем финансирования: 29 858 850 тенге